最新新闻

热点文章

我要投稿

联系电话:027-87592219/20/21转188

投稿邮箱:tb@e-works.net.cn

投稿邮箱:tb@e-works.net.cn

文章推荐

视频推荐

- 未来汽车工厂,在线下单支持私人定制

- 2018-02-02

- 基于云端的三维CAD系统Autodesk Fusion 360

- 2018-01-31

- 通过PTC物联网技术实现Flowserve泵的预测性维护

- 2018-01-31

- 微软预测性维护保障电梯高效服务

- 2018-01-30

深度解析:移动机器人的几种视觉算法

如果对移动机器人视觉算法进行拆解,你就会发现获取物体深度信息、定位导航以及壁障等都是基于不同的视觉算法,本文就带大家聊一聊几种不同但又必不可少的视觉算法组成。

过去认为很难实时运行的双目匹配算法,即使在没有主动结构光辅助的情况下,也表现出非常优异的3D成像质量。Segway robot采用了主动/被动可切换的双目深度视觉系统。如下图所示,

左侧三个传感器分别为,左红外相机,红外pattern投影,右红外相机。在室内工作时,因为红外光源不足,红外投影打开,辅助双目匹配算法。在室外工作时,红外光源充足,红外投影关闭,双目匹配算法可以直接运行。综合看,此系统在室内外都表现出优异的深度传感能力。

算法二:定位导航

Q:视觉处理后,机器人是如何实现导航的?

深度解析:移动机器人的几种视觉算法

机器人导航本身是一个比较复杂的系统。其中涉及到的技术会有如下列表:

-

视觉里程计 VO

-

建图,利用VO和深度图

-

重定位,从已知地图中识别当前的位置

-

闭环检测·,消除VO的闭环误差

-

全局导航

-

视觉避障

- Scene tagging,识别房间中物体加上tag

机器人开机,视觉里程计就会开始工作,记录从开机位置起的6DOF定位信息。在机器人运动过程中,mapping算法开始构建机器人看到的世界,将空间中丰富的特征点信息,二维的地图信息记录到机器人map中。

当机器人运动过程中因为遮挡、断电等原因丢失了自身的坐标,重定位算法就需要从已知地图中定位到机器人当前的位置估计。另外,当机器人运动中回到了地图中曾经出现过的位置,往往视觉里程计的偏差会导致轨迹并没有完全闭合,这就需要闭环算法检测和纠正这个错误。

有了全局地图之后,机器人就可以给定一些目标点指令,做全局的自主导航了。在现实中,因为环境是不停变化的,全局地图并不能完全反映导航时的障碍物状况,因此需要凌驾于全局导航之上的视觉避障算法进行实时的运动调整。

最后,一个自动的导航系统还需要机器人自动识别和理解空间中的不同物体的信息、位置、高度和大小。这些tag信息叠加在地图上,机器人就可以从语义上理解自己所处的环境,而用户也可以从更高层次下达一些指令。

Q:视觉VSLAM在机器人上的实现有哪些难点?

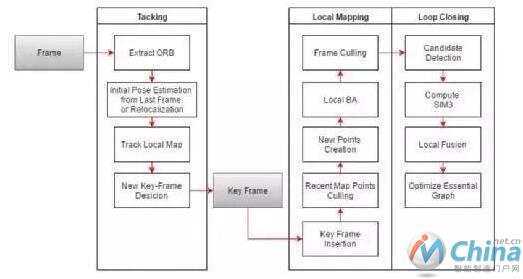

视觉VSLAM是一个集合了视觉里程计,建图,和重定位的算法系统。近年来发展很快。基于特征的视觉SLAM算法从经典的PTAM算法开端,目前以ORB-SLAM为代表的算法已经可以在PC上达到实时运行。下面是一个ORBSLAM的框图:

从名字可见,其使用ORB作为图像特征提取工具,并且在后续的建图及重定位中均使用了同一份特征点信息。相对于传统的SIFT和SURF特征提取算法,其效率高出很多。

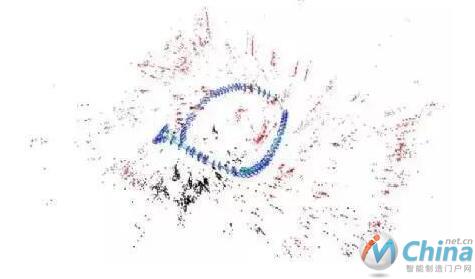

ORB-SLAM包含三个并行的线程,即跟踪,建图和闭环。其中跟踪线程运行在前端,保证实时运行,建图和闭环线程运行在后端,速度不需要实时,但是与跟踪线程共享同一份地图数据,可以在线修正使得地图数据精度和跟踪精度更高。下图是ORB-SLAM地图的主要数据结构,

点云和关键帧。两者之间通过图像上2D特征点与空间中的点云建立映射关系,同时还维护了关键帧之间的covisibility graph关系。通过这些数据关联,用优化方法来维护整个地图。

本文来源于互联网,e-works本着传播知识、有益学习和研究的目的进行的转载,为网友免费提供,并以尽力标明作者与出处,如有著作权人或出版方提出异议,本站将立即删除。如果您对文章转载有任何疑问请告之我们,以便我们及时纠正。联系方式:editor@e-works.net.cn tel:027-87592219/20/21。

- 上一篇文章:机床与大数据实现强强联合

- 下一篇文章:改善机床利用率的基本方法