最新新闻

热点文章

我要投稿

联系电话:027-87592219/20/21转188

投稿邮箱:tb@e-works.net.cn

投稿邮箱:tb@e-works.net.cn

文章推荐

视频推荐

- 未来汽车工厂,在线下单支持私人定制

- 2018-02-02

- 基于云端的三维CAD系统Autodesk Fusion 360

- 2018-01-31

- 通过PTC物联网技术实现Flowserve泵的预测性维护

- 2018-01-31

- 微软预测性维护保障电梯高效服务

- 2018-01-30

深度解析:移动机器人的几种视觉算法

如果对移动机器人视觉算法进行拆解,你就会发现获取物体深度信息、定位导航以及壁障等都是基于不同的视觉算法,本文就带大家聊一聊几种不同但又必不可少的视觉算法组成。

深度相机是另一大类视觉算法中需要的传感器,可以分成如下几类:

1.TOF传感器(例如Kinect 2代),类似昆虫复眼。成本高,室外可以使用。

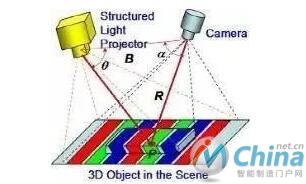

2.结构光传感器(例如Kinect 1代),三角定位原理,成本中,室外不能用。

3.双目视觉(例如Intel Realsense R200),主动照明或被动照明,IR或可见光皆可。成本低,室外可以使用。

算法一:深度信息提取

Q:深度相机如何识别物体的深度信息的呢?

简而言之,其原理就是使用两个平行的相机,对空间中的每个点三角定位。通过匹配左右两个相机中成像点的位置,来计算对应三维点在空间中的距离。学术界对双目匹配恢复深度图研究有很长的历史,在NASA火星车上就开始采用这个技术。但是其真正在消费电子品市场得到广泛应用还是从微软的Kinect体感传感器开始。

Kinect传感器背后使用了以色列Primesense公司授权的结构光技术(如今已被Apple收购)。其原理是避开双目匹配中复杂的算法设计,转而将一个摄像头更换成向外主动投射复杂光斑的红外投影仪,而另一个平行位置的相机也变成了红外相机,可以清楚的看到投影仪投射的所有光斑。因为人眼看不到红外光斑,而且纹理非常复杂,这就非常有利于双目匹配算法,可以用非常简洁的算法,识别出深度信息。

尽管Kinect的内在原理官方并没有给出解释,在近年来一篇Kinect Unleashed的文章中,作者向公众hack了这个系统的工作原理:

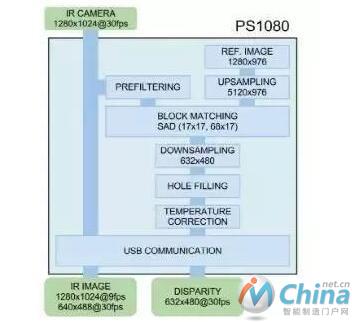

首先,红外图像在基线方向上采样8倍,这样可以保证在做双目匹配后实现3bit的亚像素精度。然后,对图像做sobel滤波,使得图像的匹配精度提高。而后,图像与预存的投影光斑模板图像进行SAD block matching。该算法的计算复杂度小,适合硬化和并行。最后,经过简单的图像后处理,下采样到原始分辨率,得到最终的深度图。

我们可以看到,随着2009年Kinect设备在消费机市场的爆发(发售头10天100万台),逐渐开始催生了类似技术变种在移动端设备的研发热潮。从2013年至今,随着计算能力的提升和算法的进步,硬件成本更低的主动/被动双目深度相机开始在移动手机上涌现。

本文来源于互联网,e-works本着传播知识、有益学习和研究的目的进行的转载,为网友免费提供,并以尽力标明作者与出处,如有著作权人或出版方提出异议,本站将立即删除。如果您对文章转载有任何疑问请告之我们,以便我们及时纠正。联系方式:editor@e-works.net.cn tel:027-87592219/20/21。

- 上一篇文章:机床与大数据实现强强联合

- 下一篇文章:改善机床利用率的基本方法